Dies ist keine wirkliche Antwort auf Ihre Frage, im Wesentlichen, weil Ihr Beitrag keine ( derzeit) Frage enthält, aber für einen Kommentar zu lang ist.

Ihre Aussage, dass

eine Koordinatentransformation eine lineare Abbildung von einem Vektor auf sich selbst mit einer Änderung der Basis ist.

ist durcheinander und letztendlich falsch. Nehmen Sie einen Vektorraum $ V $ und zwei Basen $ \ beta $ und $ \ gamma $ für $ V $. Jede dieser Basen kann verwendet werden, um eine Repräsentationskarte $ r_ \ beta: \ mathbb R ^ n \ zu V $ zu erstellen, die durch $$ r_ \ beta (v) = \ sum_ {j = 1} ^ nv_j e_j $$ gegeben ist wenn $ v = (v_1, \ ldots, v_n) $ und $ \ beta = \ {e_1, \ ldots, e_n \} $. Die Koordinatentransformation ist keine lineare Abbildung von $ V $ zu sich selbst. Stattdessen ist es die Karte $$ r_ \ gamma ^ {- 1} \ circ r_ \ beta: \ mathbb R ^ n \ zu \ mathbb R ^ n, \ tag 1 $$ und nimmt Koordinaten zu Koordinaten.

Um auf den Punkt Ihrer Verwirrung zu kommen, sollte betont werden, dass Covektoren keine Mitglieder von $ V $ sind. Daher gelten die Darstellungskarten in keiner Weise direkt für sie. Stattdessen gehören sie zum dualen Raum $ V ^ \ ast $, mit dem Sie hoffentlich vertraut sind. (Im Allgemeinen würde ich Sie dringend davon abhalten, Texte zu lesen, die vorgeben, das Gesetz zur Unterscheidung zwischen Vektoren und Covektoren festzulegen, ohne ausführlich über den dualen Raum zu sprechen.)

Der duale Raum ist der Vektorraum aller linearen Funktionen von $ V $ in sein Skalarfeld: $$ V = \ {\ varphi: V \ bis \ mathbb R: \ varphi \ text {ist linear} \}. $$ Dies hat dieselbe Dimension wie $ V. $, und jede Basis $ \ beta $ hat eine eindeutige doppelte Basis $ \ beta ^ * = \ {\ varphi_1, \ ldots, \ varphi_n \} $, gekennzeichnet durch $ \ varphi_i (e_j) = \ delta_ {ij} $. Da es sich um eine andere Basis als $ \ beta $ handelt, ist es nicht überraschend, dass die entsprechende Darstellungskarte unterschiedlich ist.

Um die Darstellungskarte in den Raum mit zwei Vektoren zu heben, muss der Begriff neben einer linearen Karte verwendet werden. Es gibt im Allgemeinen keine Möglichkeit, eine lineare Karte $ L: V \ nach W $ zu einer Karte von $ V ^ * $ nach $ W ^ * $ zu heben. Stattdessen muss man den Pfeil umkehren. Bei einer solchen Abbildung, einem funktionalen $ f \ in W ^ * $ und einem Vektor $ v \ in V $ gibt es nur eine sinnvolle Kombination, nämlich $ f (L (v)) $. Das Mapping $$ v \ mapsto f (L (v)) $$ ist ein lineares Mapping von $ V $ in $ \ mathbb R $ und daher in $ V ^ * $. Es wird mit $ L ^ * (f) $ bezeichnet und definiert die Aktion des adjungierten $$ L ^ *: W ^ * \ zu V ^ *. $$

Wenn Sie dies auf das anwenden Repräsentationskarten auf $ V $ erhalten Sie die Adjunkte $ r_ \ beta ^ *: V ^ * \ zu \ mathbb R ^ {n, *} $, wobei letzteres kanonisch $ \ mathbb R ^ n $ entspricht, weil es hat eine kanonische Basis. Die Umkehrung dieser Karte, $ (r_ \ beta ^ *) ^ {- 1} $, ist die Repräsentationskarte $ r _ {\ beta ^ *}: \ mathbb R ^ n \ cong \ mathbb R ^ {n, *} \ bis V ^ * $. Dies ist der Ursprung der 'inversen Transponierungs'-Regel zum Transformieren von Covektoren.

Um die Transformationsregel für Covektoren zwischen zwei Basen zu erhalten, müssen Sie zwei davon aneinander reihen: $$ \ left ((r_ \) gamma ^ *) ^ {- 1} \ right) ^ {- 1} \ circ (r_ \ beta ^ *) ^ {- 1} = r_ \ gamma ^ * \ circ (r_ \ beta ^ *) ^ {- 1 }: \ mathbb R ^ n \ bis \ mathbb R ^ n, $$, was sich sehr von dem für Vektoren unterscheidet, (1).

Denken Sie immer noch, dass Vektoren und Covektoren dasselbe sind?

Nachtrag

Lassen Sie mich abschließend ein weiteres Missverständnis in Ihrer Frage ansprechen:

Ein inneres Produkt befindet sich zwischen Elementen desselben Vektorraums und nicht zwischen zwei Vektorräumen, es ist nicht so, wie es definiert ist.

Innere Produkte werden tatsächlich definiert, indem beide Eingaben aus demselben Vektorraum entnommen werden. Trotzdem ist es immer noch durchaus möglich, eine bilineare Form $ \ langle \ cdot, \ cdot \ rangle zu definieren: V ^ * \ times V \ to \ mathbb R $, die einen Covektor und einen Vektor benötigt, um einen Skalar zu ergeben; es ist einfach die Aktion des ersteren auf das letztere: $$ \ langle \ varphi, v \ rangle = \ varphi (v). $$

Diese bilineare Form ist immer garantiert und setzt eine streng weniger Struktur als ein inneres Produkt voraus. Dies ist das 'innere Produkt', das in Einstein-Notation $ \ varphi_j v ^ j $ lautet.

Dies bezieht sich natürlich auf die innere Produktstruktur $ \ langle \ cdot, \ cdot \ rangle_ \ text {I.P.} $ auf $ V $, wenn es eine gibt. Eine solche Struktur ermöglicht es, Vektoren und Covektoren auf kanonische Weise zu identifizieren: Wenn ein Vektor $ v $ in $ V $ gegeben ist, ist sein entsprechender Covektor die lineare Funktion $$ \ begin {align} i (v) = \ langle v, \ cdot \ rangle_ \ text {IP}: V& \ longrightarrow \ mathbb R \\ w& \ mapsto \ langle v, w \ rangle_ \ text {IP}. \ end {align} $$ Konstruktionsbedingt sind beide bilinearen Formen kanonisch verwandt , so dass das 'innere Produkt' $ \ langle \ cdot, \ cdot \ rangle $ zwischen $ v \ in V ^ * $ und $ w \ in V $ genau das gleiche ist wie das innere Produkt $ \ langle \ cdot, \ cdot \ rangle_ \ text {IP} $ zwischen $ i (v) \ in V $ und $ w \ in V $. Dieser Sprachgebrauch ist vollkommen gerechtfertigt.

Anhang 2 zu Ihrer Frage zum Gradienten.

Ich sollte wirklich versuchen, Sie an dieser Stelle davon zu überzeugen, dass die Transformationsgesetze gelten in der Tat genug, um etwas zu zeigen, ist ein Covector. (Das Argument lautet, dass man eine lineare Funktion auf $ V $ über das von den Komponenten angegebene Formular in $ \ mathbb R ^ {n *} $ definieren kann und die Transformationsgesetze sicherstellen, dass dieses Formular in $ V ^ * $ ist unabhängig von der Basis; alternativ geben die Darstellungskarten angesichts der Komponenten $ f_ \ beta, f_ \ gamma \ in \ mathbb R ^ n $ in Bezug auf zwei Basen die Formen $ r _ {\ beta ^ *} (f_) an \ beta) = r _ {\ gamma ^ *} (f_ \ gamma) \ in V ^ * $, und die beiden sind aufgrund der Transformationsgesetze gleich.)

Es gibt jedoch tatsächlich einen tieferen Grund für die Tatsache, dass der Gradient ein Covektor ist. Im Wesentlichen hat dies damit zu tun, dass die Gleichung $$ df = \ nabla f \ cdot dx $$ eigentlich kein Punktprodukt benötigt; Stattdessen basiert es auf der einfacheren Struktur der bilinearen Dual-Primal-Form $ \ langle \ cdot, \ cdot \ rangle $.

Um dies zu präzisieren, betrachten Sie eine beliebige Funktion $ T: \ mathbb R ^ n \ bis \ mathbb R ^ m $. Die Ableitung von $ T $ bei $ x_0 $ ist definiert als die (eindeutige) lineare Abbildung $ dT_ {x_0}: \ mathbb R ^ n \ zu \ mathbb R ^ m $, so dass $$ T (x) = T ( x_0) + dT_ {x_0} (x-x_0) + O (| x-x_0 | ^ 2), $$ falls vorhanden. Der Gradient ist genau diese Karte; Es wurde als lineares Funktional geboren, dessen Koordinaten über jede Basis $ \ frac {\ partielle f} {\ partielle x_j} $ sind, um sicherzustellen, dass die mehrdimensionale Kette Regel, $$ df = \ sum_j \ frac {\ teilweise f} {\ teilweise x_j} d x_j, $$ ist erfüllt. Um Studenten, die noch nicht mit 1D-Kalkül vertraut sind, das Verständnis zu erleichtern, wird diese lineare Karte meistens als entsprechender Vektor "verkleidet", der durch die euklidische Struktur eindeutig erhältlich ist und dessen Wirkung daher durch diesen euklidischen zurückgehen muss Struktur, um zum ursprünglichen $ df $ zu gelangen.

Anhang 3.

OK, es ist jetzt irgendwie klar, was die Hauptfrage ist (es sei denn, das ändert sich erneut). obwohl es immer noch im Fragentext nicht besonders klar ist. Das, was adressiert werden muss, ist in der Antwort des OP in diesem Thread angegeben:

Der duale Vektorraum ist selbst ein Vektorraum, und die Tatsache, dass er als Zeilenmatrix abgelegt werden muss, basiert darüber, wie wir lineare Karten berechnen und nicht darüber, was lineare Karten tatsächlich sind. Wenn ich die Matrixmultiplikation anders definiert hätte, wäre dies nicht geschehen.

Ich werde auch diese Frage ansprechen: vorausgesetzt, der duale (/ cotangent) Raum ist auch Was zwingt uns, einen Vektorraum so weit vom Ursprünglichen zu unterscheiden, dass wir ihn als Zeilenvektoren anstelle von Spalten anzeigen und sagen, dass seine Transformationsgesetze unterschiedlich sind?

Der Hauptgrund dafür wird von Christoph in seiner Antwort gut angesprochen, aber ich werde darauf näher eingehen. Die Vorstellung, dass etwas Co- oder Contra-Variante ist, ist im Vakuum nicht gut definiert. Wörtlich bedeuten die Begriffe "variiert mit" und "variiert gegen" und sie sind bedeutungslos, es sei denn, man sagt , was das betreffende Objekt mit oder gegen variiert.

Bei der linearen Algebra beginnt man mit einem gegebenen Vektorraum, $ V $. Die nicht angegebene Referenz ist immer die Basis von $ V $: Kovariante Objekte transformieren sich genau wie die Basis, und kontravariante Objekte verwenden die Transponierungsumkehrung der Koeffizientenmatrix der Basistransformation.

Man kann, von Drehen Sie natürlich den Spieß um und konzentrieren Sie sich auf das Duale, $ W = V ^ * $. In diesem Fall wird das ursprüngliche $ V $ jetzt zum Dualen, $ W ^ * = V ^ {**} \ cong V $ . In diesem Fall transformieren sich Größen, die früher mit der Urbasis transformiert wurden, jetzt gegen die Doppelbasis und umgekehrt. Genau deshalb nennen wir es das Duale: Es gibt eine vollständige Dualität zwischen den beiden Räumen.

Wie überall in der Mathematik, wo zwei vollständig duale Räume berücksichtigt werden ( Beispiel, Beispiel, Beispiel , Beispiel, Beispiel) muss man diese Symmetrie brechen, um irgendwohin zu gelangen. Es gibt zwei Klassen von Objekten, die sich unterschiedlich verhalten, und eine Transformation, die die beiden vertauscht. Dies hat zwei unterschiedliche, verwandte Vorteile:

- Alles, was man für eine Gruppe von Objekten beweist, hat eine doppelte Tatsache, die automatisch bewiesen wird.

- Daher muss man immer nur eine beweisen Version der Anweisung.

Wenn man Vektortransformationsgesetze betrachtet, hat (oder kann oder sollte) man immer im Hinterkopf die Tatsache, dass man die Sprache in Bezug auf die dualitätstransformierten Objekte umformulieren kann. Da jedoch der Inhalt der Anweisungen durch die Umwandlung nicht geändert wird, ist es normalerweise nicht sinnvoll, die Umwandlung durchzuführen: Man muss eine -Version angeben, und es gibt keine wirklich Jeder Punkt, an dem beides angegeben wird. Somit bricht einer (willkürlich -ish) die Symmetrie, rollt mit dieser Version und ist sich bewusst, dass eine duale Version der gesamten Entwicklung ebenfalls möglich ist.

Diese duale Version ist jedoch nicht das gleiche. Covektoren können in der Tat als Zeilenvektoren in Bezug auf eine Basis von Covektoren ausgedrückt werden, und die Koeffizienten von Vektoren in $ V $ würden dann mit der neuen Basis anstatt gegen variieren, aber dann würden für jede tatsächliche Implementierung die Matrizen, die Sie verwenden würden Natürlich wird die Dualität transformiert. Sie hätten die Sprache geändert, aber nicht den Inhalt.

Schließlich ist zu beachten, dass die beiden Objekte zwar gleichwertig sind, jedoch nicht gleich sind. Deshalb nennen wir sie dual, anstatt einfach zu sagen, dass sie gleich sind! In Bezug auf Vektorräume muss man also noch beweisen, dass $ V $ und $ V ^ * $ nicht nur doppelt verwandt, sondern auch unterschiedlich sind. Dies wird in der Aussage präzisiert, dass es keinen natürlichen Isomorphismus zwischen einem Vektorraum und seinem dualen gibt, der in der Sprache der Kategorietheorie formuliert und bewiesen ist. Der Begriff des "natürlichen" Isomorphismus ist schwierig, würde aber Folgendes implizieren:

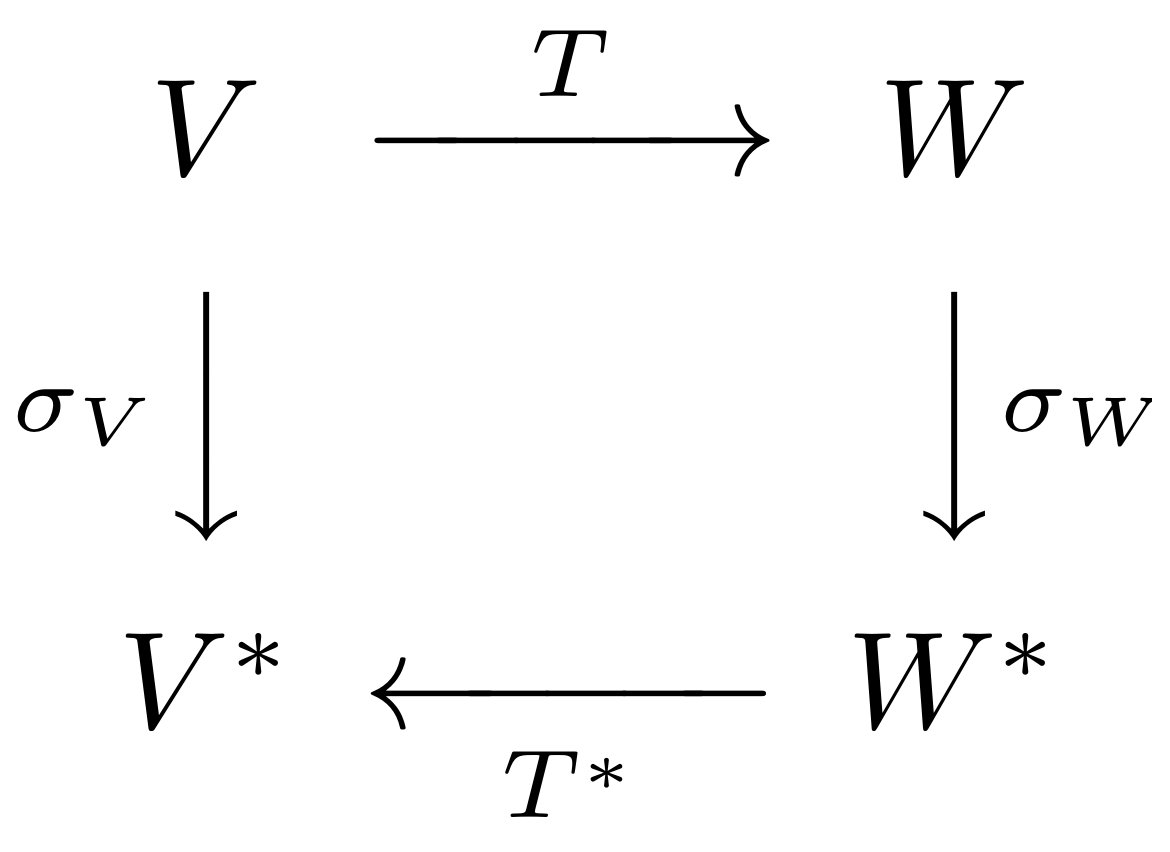

Für jeden Vektorraum $ V $ hätten Sie einen Isomorphismus $ \ sigma_V: V \ zu V ^ * $. Sie möchten, dass dieser Isomorphismus gut mit der Dualitätsstruktur und insbesondere mit den Dualen linearer Transformationen, d. H. Ihren Adjunkten, zusammenspielt. Das bedeutet, dass Sie für alle Vektorräume $ V, W \ in \ mathrm {Vect} $ und jede lineare Transformation $ T: V \ zu W $ das Diagramm

p möchten >

p möchten >

pendeln. Das heißt, Sie möchten, dass $ T ^ * \ circ \ sigma_W \ circ T $ gleich $ T $ ist.

Dies ist nachweislich nicht konsistent möglich. Der Grund dafür ist, dass wenn $ V = W $ und $ T $ ein Isomorphismus ist, $ T $ und $ T ^ * $ unterschiedlich sind, aber für ein einfaches Gegenbeispiel können Sie einfach ein reales Vielfaches der Identität nehmen als $ T $. Dies ist genau die formale Aussage der Intuition in garyps großartiger Antwort.

In Apfel-Birnen-Sprachen bedeutet dies, dass ein allgemeiner Vektorraum $ V $ und sein dual $ V ^ * $ sind nicht nur dual (in dem Sinne, dass es eine Transformation gibt, die sie umschaltet und bei zweimaliger Anwendung zurücksetzt), sondern sie unterscheiden sich auch (in dem Sinne, dass es keine einheitliche Möglichkeit gibt, sie zu identifizieren). Aus diesem Grund ist die Dualitätssprache gerechtfertigt.

Ich habe ziemlich viel herumgeschlendert, und hoffentlich ist zumindest ein Teil davon hilfreich. Zusammenfassend muss ich jedoch die Tatsache wegnehmen, dass

Nur weil zwei Objekte gleichwertig sind, heißt das nicht, dass sie gleich sind.

Dies ist übrigens auch eine direkte Antwort auf den Fragentitel: Nein, es ist nicht dumm. Sie sind gleichwertig, aber immer noch unterschiedlich.